Recientemente tuvo lugar una nueva edición de “Respuestas SIC”, unas jornadas que periódicamente organiza la revista SIC y a las que tuve la oportunidad de asistir.

Esta edición tenía como título: “Protección de vanguardia ante APTs y DDoS: Nuevos ataques, mejores defensas” y tuvo tres bloques. En el primero, un especialista en protección de la información (Juan Miguel Velasco López-Urda) ofreció una charla sobre su visión ante la defensa frente a APTs. En el segundo bloque, siete fabricantes de seguridad TI (Check Point, Corero, Fortinet, HP, Stonesoft, Symantec y Trend Micro) explicaron sus orientaciones en materia de protección frente a APTs y DDoS. El tercer bloque contó con la participación del Centro Criptológico Nacional representado por su subdirector General Adjunto, Luis Jiménez Muñoz, y dos organizaciones privadas: Arsys (Olof Sandstrom Herrera, Director de operaciones y seguridad) y Telefónica Digital (Santiago Perez) y consistió en una mesa redonda en la cual se trató la visión de los usuarios/centros de competencia al respecto de los temas tratados (APTs y DDos) además de hablar sobre los escenarios actuales, limitaciones y necesidades futuras.

A continuación, en esta y sucesivas entradas realizaré una breve crónica de la jornada.

BLOQUE 1: Protección ante APTs y DDoS. Situación presente.

Juan Miguel Velasco López-Urda

Consultor Estrátegico de Seguridad y Cloud para Grandes Corporaciones

Juan Miguel comenzó mencionando, entre otros, que en 2014 se prevé que habrá más dispositivos conectados que habitantes en la Tierra (fuente: Gartner) —hizo hincapié en la tendencia en auge BYOD y en que ésto crea un perímetro que no se puede cerrar— y que actualmente los ciberataques según el World Economic Forum se encuentran en 4º lugar como potenciales riesgos globales en cuanto a probabilidad que puedan afectarnos (por detrás del aumento de emisiones de gases de efecto invernadero).

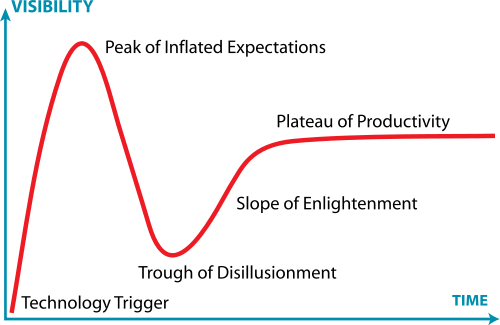

Definió las APTs (Advanced Persistent Threats) como una categoría de cibercrimen dirigido contra objetivos empresariales y gubernamentales cuya máxima es “atacar de manera lenta y silenciosa” y que son un tipo de servicio demandado por competidores, cazarrecompensas, gobiernos, servicios de inteligencia, etc.

Asemejó sus técnicas con técnicas de estrategia militar y mencionó Stuxnet, Aurora, Flame, Shady RAT, GhostNet, Night Dragon, Nitro, y la última ‘saltada a la palestra’ cuya misión es la búsqueda y robo de ficheros Autocad, Medre (creo que así se ha bautizado). Habló incluso de APTs para PC de usuarios con objetivo el robo de identidad.

Describió como fases por las que se pasa cuando se descubre una APT en un organismo las siguientes: Denial, Shock, Attribution & Retribution, Investigation & Discovery, Realization y Resolution. Según Juan Miguel, en España nos quedamos en las tres primeras fases (‘esto no me puede pasar a mi’,’estado de shock’,’echar las culpas’), y es algo que hay que cambiar.

Como principal vía de entrada para una APT habló del phishing dirigido y del BYOD como nueva puerta de entrada (además de otras puertas de entrada como fallos en el perímetro externo: Firewall, VPN Server, Proxy, aplicaciones web vulnerables, navegación web, perímetro interno: ingeniería social, USBs, …etc) y citó algunos precios reales de lo que costaría planear una campaña de APT:

- RAT: Gratuito.

- Servicio de phishing dirigido : Setup de 2000$, coste mensual de 2000 $.

- Dos 0-day: 40.000 $.

- Rent-a-hacker: unos 20.000 $ al mes.

Habló de los ataques de DDoS como método de distracción para llevar otros ataques más sofisticados y los caracterizó como ataques universales (te puede pasar donde sea, a quien sea y cuando sea), baratos, eficientes, impunes (gracias al anonimato que dan las botnets), de gran impacto, reiteradamente posibles y menospreciados.

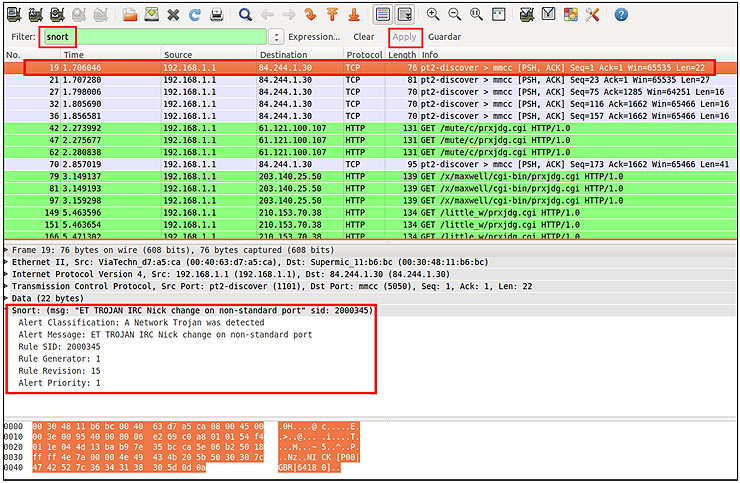

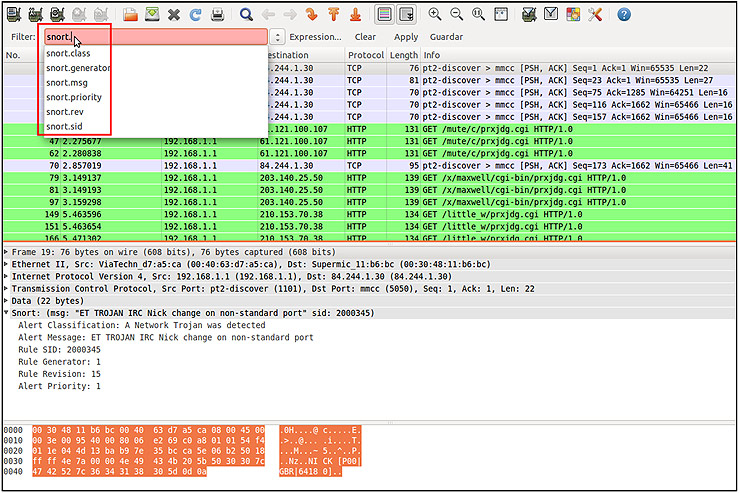

Ante cómo defenderse frente a una APT comentó que los elementos tradicionales y de defensa han de ser desplegados, monitorizados en tiempo real y recopilados todos los logs para su análisis y almacenamiento. Al menos hay que tener todos los Proxy Logs, Authentication Logs, IDS alerts, HIDS logs, Firewall logs, Full content traffic captures, Netflow, aplicaciones (datos y errores) y auditoría con activación proactiva.

Algunas conclusiones extraídas de esta interesante charla del señor Velasco fueron las siguientes.

1) Frente a defensa de APTs:

- Diseñar el perímetro (Firewalls, IPS, WAF, habló del cloud como protagonista como tercer perímetro y de la necesidad de monitorizarlo y auditarlo de manera periódica. Éste debe ser una extensión de nuestro perímetro exterior asumiendo nuestra política y reglas).

- Implementar contramedidas antiDDoS (implementando un modelo híbrido cloud).

- Implantar protección email (Antispam, email firewall).

- Análisis de código Web y politicas de diseño Web y código.

- Monitorizar toda la información que entra y sale.

- Restringir el acceso a BYOD.

- Segmentar la red y el acceso a los usuarios.

2) Sobre la situación actual respecto a APTs y DDoS, destacó que:

- Cada día aparece nuevo malware, nuevos 0-day, nuevas vulnerabilidades… y nuevas APT aprovechándose de ello. Por otro lado los ataques DDoS son favorecidos por la proliferación de las botnets, y además comienzan a tener un ‘toque de sofisticación’ puesto que ya no son volumétricos, sino que también son dirigidos.

- El perímetro comienza a perder los límites establecidos por el exceso de tráfico no catalogado, la heterogeneidad de las aplicaciones, la necesidad de que el usuario sea capaz de conectarse desde cualquier parte y a través de cualquier dispositivo. Por tanto se ha de redimensionar de manera adecuada este perímetro y sobre todo incluir monitorización en el mismo y correlación continua y gestionada. Además, los servicios en la nube podrían ayudarnos como una evolución de nuestro perímetro.

- La incorporación de tecnologías antiDDoS, la simulación de entornos con SandBox virtuales y los analizadores de tráfico dinámicos no basados en firmas ayudarían en la ‘lucha’ contra las APTs y los DDoS.

En la tanda de preguntas resaltar la opinión de una persona que afirmó que es imposible parar BYOD; se trata de una tendencia imparable y que hay que elegir bien la tecnología y buscar un equilibrio. Otra persona comentó que a veces dudaba de si las vulnerabilidades las anunciaban los mismos que nos venden ‘la solución’: los fabricantes.

En definitiva, el bloque 1 de las jornadas, de la mano de Juan Miguel Velasco, aportó una visión muy clara sobre la situación presente ante las nuevas, avanzadas y persistentes amenazas que están presentes en el panorama actual. En la próxima entrada acabaré la crónica de esta jornada, con el bloque 2 y 3. Mientras, os lanzo una de las interesantes preguntas que surgieron a lo largo del día:

¿Creéis que los fabricantes de herramientas TIC están orientando de manera adecuada sus desarrollos con fines de seguridad y protección frente a las nuevas amenazas que se nos están viniendo encima?

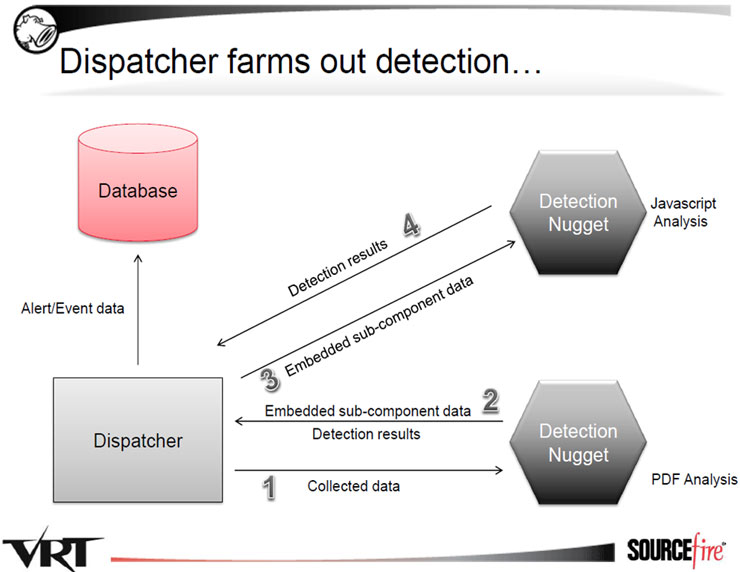

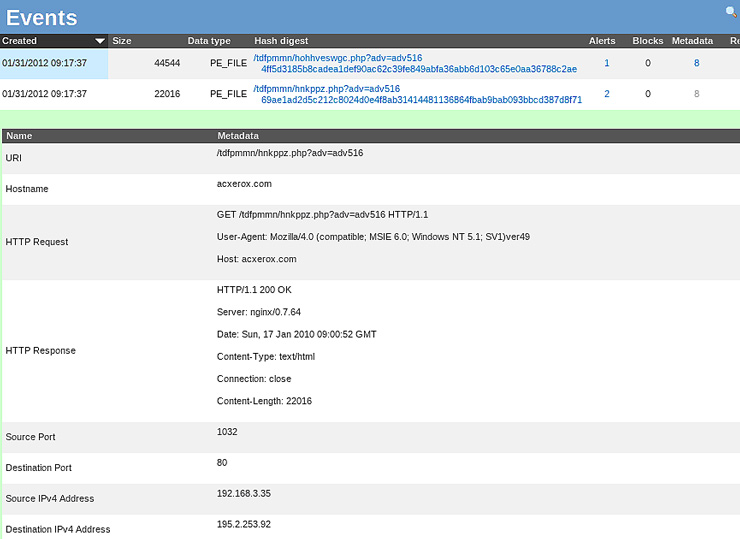

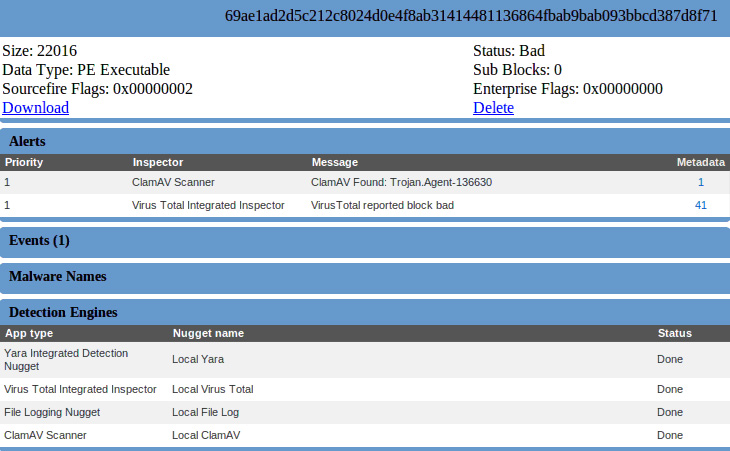

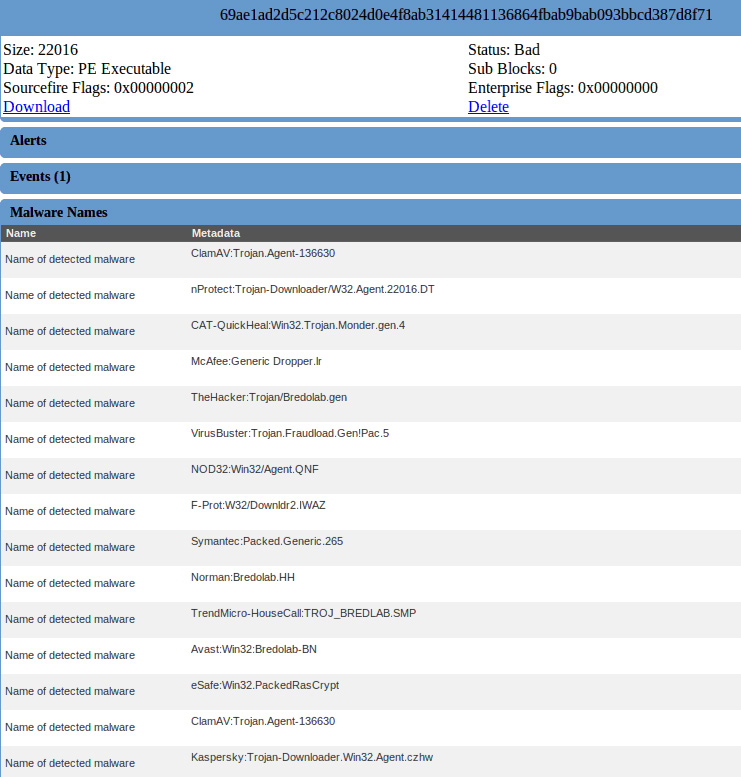

Recientemente comentábamos entre los compañeros cómo han disminuido, en general, los ataques dirigidos a servidores, aumentando especialmente, por contra, los ataques al usuario. Dichos ataques están siendo cada vez más sofisticados ya que intentan explotar vulnerabilidades muy avanzadas a nivel de cliente, sobretodo a la hora de procesar ficheros “complejos”, como DOC o PDF.

Recientemente comentábamos entre los compañeros cómo han disminuido, en general, los ataques dirigidos a servidores, aumentando especialmente, por contra, los ataques al usuario. Dichos ataques están siendo cada vez más sofisticados ya que intentan explotar vulnerabilidades muy avanzadas a nivel de cliente, sobretodo a la hora de procesar ficheros “complejos”, como DOC o PDF.