Para aquellos profesionales que estén buscando ampliar conocimientos (o gestores intentando exprimir el presupuesto departamental) y hayan pensado en realizar alguna certificación o curso, a continuación se proponen un listado de las principales certificaciones relacionadas, directa o tangencialmente, con el área de la seguridad informática. No están todas las que son, pero sí son todas las que están:

- ITIL. Marco de trabajo de las mejores prácticas destinadas a facilitar la entrega de servicios de tecnologías de la información (TI) de alta calidad. Ofrecido por la OGC británica (Office of Government Commerce UK).

- CISSP (Certified Information Systems Security Professional) de ISC2, certificación de seguridad independiente. Trata de abarcar diversos dominios de seguridad TIC, desde controles de acceso a criptografía o continuidad de negocio.

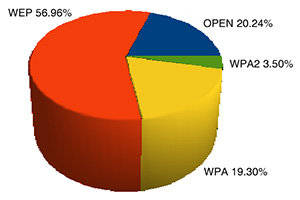

El gráfico de la izquierda establece el porcentaje de uso de cada protocolo obtenido de una muestra de 2658 puntos de acceso tomada en el escenario de pruebas, con la siguiente distribución:

El gráfico de la izquierda establece el porcentaje de uso de cada protocolo obtenido de una muestra de 2658 puntos de acceso tomada en el escenario de pruebas, con la siguiente distribución: