Para los más viejos del lugar no es necesaria ninguna presentación de Jorge Ramió; por si hay alguien que no lo conozca, Jorge es —aparte de un amigo— Doctor Ingeniero de Telecomunicación, profesor de la Universidad Politécnica de Madrid y desde hace más de dieciséis años imparte docencia en el ámbito de la seguridad, tanto en España como en Latinoamérica.

Para los más viejos del lugar no es necesaria ninguna presentación de Jorge Ramió; por si hay alguien que no lo conozca, Jorge es —aparte de un amigo— Doctor Ingeniero de Telecomunicación, profesor de la Universidad Politécnica de Madrid y desde hace más de dieciséis años imparte docencia en el ámbito de la seguridad, tanto en España como en Latinoamérica.

Criptólogo de referencia a nivel nacional, lidera además iniciativas como Criptored, red temática de criptografía y seguridad de la información, es ponente habitual en congresos de todo el mundo y por falta de espacio no podríamos citar ni una milésima parte de sus publicaciones y trabajos en la materia :)

1. Jorge, en primer lugar agradecerte tu colaboración en esta entrevista; es un lujo contar con tu opinión en este blog. La primera pregunta que nos gustaría hacerte es casi obligada. Eres una persona que lleva muchos años en el mundo de la seguridad y podemos considerarte uno de los principales referentes en Criptología a nivel nacional. ¿Cómo has visto la evolución en seguridad en nuestro país durante estos años? ¿Vamos a mejor? ¿Vamos a peor? ¿Seguimos igual?

Hola Toni, es un verdadero placer que de vez en cuando se acuerden de ti y haya gente que se interese por lo que algunos estamos haciendo, o al menos intentamos hacer, en este mundillo de la seguridad de la información. No obstante, primero que nada una aclaración necesaria: suena muy hermoso eso de criptólogo y referente a nivel nacional, pero no llegamos a tanto ni mucho menos. Es más que suficiente indicar que soy un estudioso y trabajador de la seguridad y de la criptografía y que, efectivamente y eso es verdad, llevo más de 15 años dedicado a la seguridad.

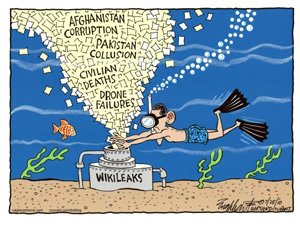

Ahora que ha pasado un cierto tiempo desde el escándalo de la publicación de los

Ahora que ha pasado un cierto tiempo desde el escándalo de la publicación de los

No sé si son ustedes conscientes de que si han adquirido un móvil a través de una operadora de telefonía sujeto a un contrato de permanencia, una vez éste ha expirado la operadora de telefonía está obligada a proporcionarles el código de liberación; y les anticipo que si les dicen que el trámite de obtención de dicho código llevará de diez a quince días, mienten. El caso, y lo que es pertinente a esta entrada, es que el pasado sábado llame para realizar dicha gestión “en nombre” de mi pareja (les confieso que obtengo una extraña sensación de satisfacción “conversando” con los operadores telefónicos de los grandes proveedores de servicio como las telecos o energéticas). Lo que me llamó la atención y me dejó descolocado fue que, después de haberle dado a la operadora todos los datos correctamente, incluyendo DNI, nombre y apellidos, IMEI, número de teléfono, marca y modelo, y lugar y fecha aproximada de compra (algo, esto último, que no está escrito en ningún sitio), debió pensar que una voz de hombre no es propia de una mujer, y me pidió hablar con ella. Claro está que la operadora no tenía medio de saber que ella era quien decía ser, pero al parecer, eso la satisfizo, porque un par de minutos después, retomamos la conversación, asegurada ya la autenticidad de mi petición por una voz de mujer que podía ser la de cualquiera.

No sé si son ustedes conscientes de que si han adquirido un móvil a través de una operadora de telefonía sujeto a un contrato de permanencia, una vez éste ha expirado la operadora de telefonía está obligada a proporcionarles el código de liberación; y les anticipo que si les dicen que el trámite de obtención de dicho código llevará de diez a quince días, mienten. El caso, y lo que es pertinente a esta entrada, es que el pasado sábado llame para realizar dicha gestión “en nombre” de mi pareja (les confieso que obtengo una extraña sensación de satisfacción “conversando” con los operadores telefónicos de los grandes proveedores de servicio como las telecos o energéticas). Lo que me llamó la atención y me dejó descolocado fue que, después de haberle dado a la operadora todos los datos correctamente, incluyendo DNI, nombre y apellidos, IMEI, número de teléfono, marca y modelo, y lugar y fecha aproximada de compra (algo, esto último, que no está escrito en ningún sitio), debió pensar que una voz de hombre no es propia de una mujer, y me pidió hablar con ella. Claro está que la operadora no tenía medio de saber que ella era quien decía ser, pero al parecer, eso la satisfizo, porque un par de minutos después, retomamos la conversación, asegurada ya la autenticidad de mi petición por una voz de mujer que podía ser la de cualquiera.