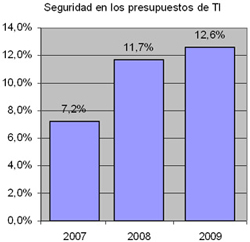

Según un estudio de Forrester, publicado en el tercer trimestre de 2008, la previsión de gasto en seguridad para 2009 mostraba una tendencia claramente ascendente, aunque a raíz de la crisis económica mundial es posible que dicha previsión se aleje de la realidad más de lo esperado. A continuación les resumo brevemente las principales conclusiones del estudio, que pueden obtener, previo pago, en este enlace de Forrester.

De manera general, tal y como puede verse en la gráfica de la izquierda, entre 2007 y 2008 (sobre un muestreo de corte radicalmente diferente), la parte del presupuesto informático ligado a los gastos en seguridad progresó de una manera importante, pasando de 7,2% al 11,7%. Este aumento que puede interpretarse como la toma de conciencia por parte de las empresas de la necesidad de inversión en seguridad.

De manera general, tal y como puede verse en la gráfica de la izquierda, entre 2007 y 2008 (sobre un muestreo de corte radicalmente diferente), la parte del presupuesto informático ligado a los gastos en seguridad progresó de una manera importante, pasando de 7,2% al 11,7%. Este aumento que puede interpretarse como la toma de conciencia por parte de las empresas de la necesidad de inversión en seguridad.

Según el informe, este crecimiento del gasto continuará durante 2009, un dato que probablemente puede sorprender, ya que tradicionalmente los presupuestos ligados a las inversiones en Tecnología de la Información son revisados a la baja en tiempos de crisis. Una de las posibles explicaciones para dicha previsión podría ser el hecho de que el estudio de Forrester fuese realizado en el transcurso del tercer trimestre del 2008, cuando se desconocía parcialmente la magnitud de la crisis económica (como evidencia de este hecho, en septiembre de 2008 la Fed tenía los tipos de interés oficiales en el 2%, y el BCE los mantenía en el 4,75%, cuando los valores actuales son del 0%-0.25% y 1% respectivamente).

Entre 2008 y 2009, la estimación es que la asignación de medios otorgada a la seguridad debería permanecer estable. Sin embargo, hay dos ramas de IT que se benefician de una ligera alza: Se trata de la Innovación (I+D+i) y los servicios externos, entendidos éstos como servicios gestionados, consultoría y outsourcing.