La entrada de hoy viene de la mano de Gabriel Sánchez-Román Urrutia, Teniente de navío de la Armada y Analista de Ciberseguridad del MCCD. Disfruten con su lectura.

¿Cómo enfrentarse a un APT? Esa es la gran pregunta que nos hacemos los que nos dedicamos a la ciberseguridad, bien sean de empresas o de diferentes organizaciones. Recientemente, escribí un artículo en el Instituto Español de Estudios Estratégicos sobre el posible uso de las APT cómo un método de disuasión por parte de los estados, en el que comparo las APT con algo que conozco muy bien: los submarinos.

Básicamente, sus similitudes emanan de las características principales de una APT: resiliencia, anonimato e invisibilidad frente a los principios fundamentales submarinistas: seguridad, discreción y conservación de la iniciativa.

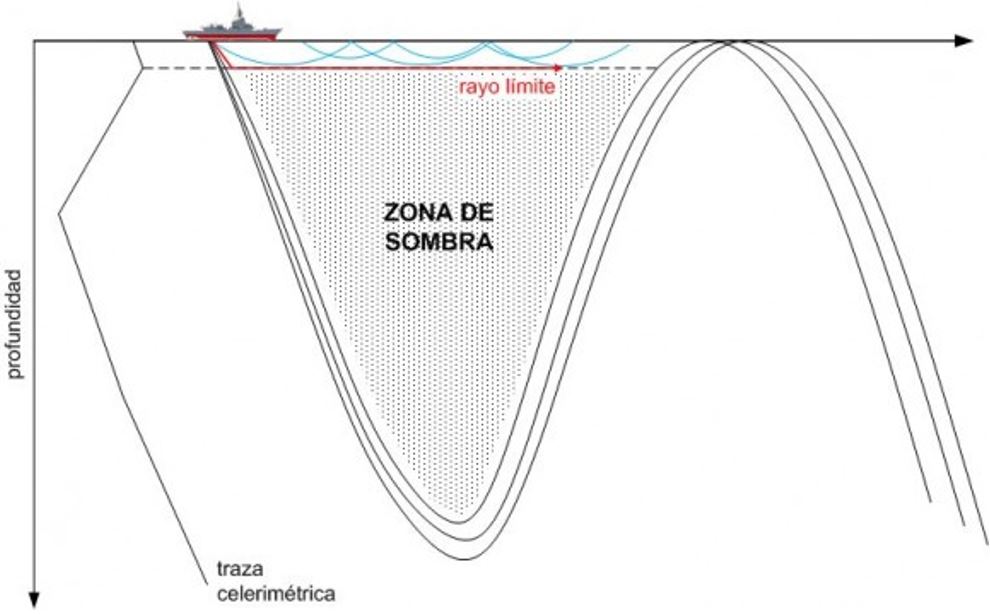

Un aspecto a tener en cuenta previamente, de forma breve, es el concepto de acústica submarina. A grandes rasgos, la velocidad del sonido en el agua depende de la temperatura, la profundidad y, en menos medida, de la salinidad y aumenta hasta un punto conocido como profundidad de capa. A partir de ahí, la velocidad del sonido (y la detección) comienza a disminuir de forma drástica y más tarde a aumentar. Es muy importante para el submarino conocer el valor de la profundidad de capa, la cual se puede conocer de forma teórica o ser medida a través de un baticelerímetro. Por lo tanto, por encima de la profundidad de capa el submarino y el buque tendrán mejor detección el uno del otro, mientras que si el submarino está por debajo de esa profundidad estará en una zona de sombra, siendo indetectable por el buque salvo que utilice sonares de profundidad variable. Aquí está el juego del ratón y el gato entre buque y submarino, algo parecido a lo que ocurre en el ciberespacio con las APT.

Muchas compañías son conscientes de que la información es uno de sus principales activos y por ello invierten cada vez más en protocolos y medidas de seguridad. Los expertos en seguridad saben que el propio usuario es uno de los principales vectores de riesgo y por eso establecen medidas para evitar estos problemas en el entorno controlado de una oficina. Estas políticas entran en colisión directa con paradigmas cambiantes como el trabajo remoto o la posibilidad de llevar dispositivos personales a la oficina (BYOD). Aunque los expertos en seguridad establecen medidas de control para este tipo de casos, es importante que se fijen en otro problema que pasa desapercibido: la cantidad de datos personales que esos trabajadores van dejando en Internet y que pueden ser utilizados para generar vectores de ataque sobre sus compañías.

Muchas compañías son conscientes de que la información es uno de sus principales activos y por ello invierten cada vez más en protocolos y medidas de seguridad. Los expertos en seguridad saben que el propio usuario es uno de los principales vectores de riesgo y por eso establecen medidas para evitar estos problemas en el entorno controlado de una oficina. Estas políticas entran en colisión directa con paradigmas cambiantes como el trabajo remoto o la posibilidad de llevar dispositivos personales a la oficina (BYOD). Aunque los expertos en seguridad establecen medidas de control para este tipo de casos, es importante que se fijen en otro problema que pasa desapercibido: la cantidad de datos personales que esos trabajadores van dejando en Internet y que pueden ser utilizados para generar vectores de ataque sobre sus compañías.