Hace ya algún tiempo que nos encontramos en un tremendo boom de la virtualización de sistemas informáticos. Gran cantidad de empresas están migrando sus sistemas a entornos virtualizados seducidos por las grandes ventajas que aportan estos sistemas encuanto a comodidad y eficiencia.

La virtualización consiste en una capa software que corre en un sistema operativo anfitrión, y que proporciona una capa de abstracción con el hardware y con el sistema operativo que hay por debajo de dicho software. Dicha abstracción es realizada de tal manera que resulte transparente al software que se ejecuta por encima de ella, es decir, cuando instalemos un sistema operativo sobre dicha capa de abstracción, esté verá el mismo tipo de procesador, espacio de direcciones y demás características hardware que vería en una máquina física, permitiendo la ejecución sin necesidad de modificaciones del software.

Dado que multiples instancias pueden ser lanzadas, la capa de abstracción es la encargada de asignar los recursos a cada una de ellas (tiempo de CPU, memoria RAM, espacio en disco, etc), permitiendo un control centralizado de las mismas desde la máquina anfitrión. Otra de las principales ventajas que aporta esta nueva vertiente es la independencias del hardware y del sistema operativo anfitrión ya que, en caso de un fallo hardware del equipo, es posible trasladar la máquina virtual a una nueva máquina física, aunque el hardware y el sistema operativo instalado en dicha máquina sean completamente diferentes a los de la máquina original, simplemente con que dicha arquitectura sea soportada por el fabricante del sofware de virtualización.

Como podéis imaginar, la aplicación de las arquitecturas virtualizadas en los planes de contingencia de los sistemas de información es inmediata, ya que en caso de desastre, simplemente con tener hardware disponible (sin necesidad de que sea igual al original) y una copia de las máquinas virtuales es posible restaurar el funcionamiento en muy poco tiempo. Sin embargo, como suele pasar en la mayoría de los casos, ninguna solución es la panacea, sino que aporta unas ventajas y unas desventajas que hay que valorar.

Concretamente, el uso de entornos virtualizados tiene algunas implicaciones de seguridad que hay que tener muy en cuenta a la hora de diseñar este tipo de entornos, con el fin de poder controlar sus riesgos de seguridad intrínsecos y reducir dicho riesgo a un nivel residual asumible por la organización.

Pero eso será otro artículo.

No obstante, las tecnologías inalámbricas presentan algunos riesgos inherentes a su medio físico de transmisión, es decir, el aire, lo cual incorpora un factor de riesgo tanto en cuanto a eficiencia como a seguridad.

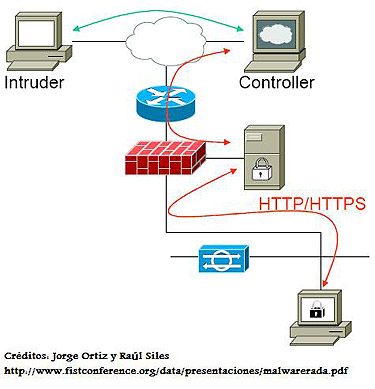

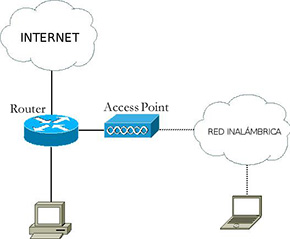

No obstante, las tecnologías inalámbricas presentan algunos riesgos inherentes a su medio físico de transmisión, es decir, el aire, lo cual incorpora un factor de riesgo tanto en cuanto a eficiencia como a seguridad. Una de las vulnerabilidades existentes en la tecnología Wifi es la posibilidad de suplantar puntos de acceso. Según el protocolo, varios puntos de accesos que presenten en mismo SSID corresponden a una misma red, por lo que cada dispositivo inalámbrico escoge de entre todos los puntos de acceso sobre los que tiene visibilidad el recibe con mayor potencia, lo cual a priori le permitirá disfrutar de una mejor calidad de señal.

Una de las vulnerabilidades existentes en la tecnología Wifi es la posibilidad de suplantar puntos de acceso. Según el protocolo, varios puntos de accesos que presenten en mismo SSID corresponden a una misma red, por lo que cada dispositivo inalámbrico escoge de entre todos los puntos de acceso sobre los que tiene visibilidad el recibe con mayor potencia, lo cual a priori le permitirá disfrutar de una mejor calidad de señal. Aunque esté lejos de controlar un lanzamiento de misiles (espero), esta reflexión viene al hilo de una serie de acusaciones realizadas desde ciertos entornos que indican que Microsoft podría tener algún tipo de puerta trasera oculta en el código del Windows Update.

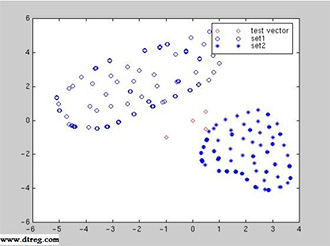

Aunque esté lejos de controlar un lanzamiento de misiles (espero), esta reflexión viene al hilo de una serie de acusaciones realizadas desde ciertos entornos que indican que Microsoft podría tener algún tipo de puerta trasera oculta en el código del Windows Update. En general, podemos aproximar la problemática de detección heurística de software malicioso a un sistema de reconocimiento automático de patrones, similar al empleado por los sistemas antispam. De esta manera, dado un elemento a analizar, se extraerían N características a considerar, con sus valores correspondientes, definiendo por tanto para este elemento un punto en un espacio N-dimensional de elementos analizados. Si la heurística seleccionada fuera lo suficientemente adecuada, observariamos agrupaciones de elementos en este espacio, tal y como se puede apreciar en la gráfica.

En general, podemos aproximar la problemática de detección heurística de software malicioso a un sistema de reconocimiento automático de patrones, similar al empleado por los sistemas antispam. De esta manera, dado un elemento a analizar, se extraerían N características a considerar, con sus valores correspondientes, definiendo por tanto para este elemento un punto en un espacio N-dimensional de elementos analizados. Si la heurística seleccionada fuera lo suficientemente adecuada, observariamos agrupaciones de elementos en este espacio, tal y como se puede apreciar en la gráfica. Durante todo este tiempo los virus han cambiado, y han pasado de propagarse junto a otro software a hacerlo a través de la red, explotando vulnerabilidades. El paso del tiempo también nos ha dejado un gran aumento de la creación de malware, debido fundamentalmente a la aparición de los virus de macro y similares, que facilitan enormemente la creación de virus por parte de personas con unos conocimientos muy limitados (existen incluso asistentes que permiten crear tu propio virus en pocos minutos), al contrario de lo que sucedía en los inicios del viring, en la que los escritores de virus eran personas con conocimientos mucho más profundos.

Durante todo este tiempo los virus han cambiado, y han pasado de propagarse junto a otro software a hacerlo a través de la red, explotando vulnerabilidades. El paso del tiempo también nos ha dejado un gran aumento de la creación de malware, debido fundamentalmente a la aparición de los virus de macro y similares, que facilitan enormemente la creación de virus por parte de personas con unos conocimientos muy limitados (existen incluso asistentes que permiten crear tu propio virus en pocos minutos), al contrario de lo que sucedía en los inicios del viring, en la que los escritores de virus eran personas con conocimientos mucho más profundos.