Para empezar la semana, hoy tenemos una entrada de uno de nuestros colaboradores habituales, Francisco Benet, sobre

Para empezar la semana, hoy tenemos una entrada de uno de nuestros colaboradores habituales, Francisco Benet, sobre ingeniería social governance. Esperamos que les guste.

Hoy me gustaría hablarles de una palabra que todo el mundo tiene últimamente en la boca: el governance. Y es que ésta es una de esas palabras que gustan… como que hace tilín. Desde Marketing hasta los más altos CEO’s, CTO’s, CIO’s, y otros tantos, hablan del governance aquí, allí, hoy y mañana. En estos últimos años he oído la palabra governance en todos los foros donde creía que podía salir y en otros tantos en que nunca me lo hubiera imaginado, y es que es pegadiza y suena bien, y de paso le da a uno esa imagen de cosmopolita que tanto gusta.

¿Que es el governance? Partamos de la base que el governance no es nada si no hay algo que gobernar. Partiendo de esta premisa, podemos aplicar governance a todo, y de hecho se aplica por defecto (ya sea bien o mal, eso es otra historia) a todas las facetas —voy a restringir el campo— de la informática empresarial (sí, empresarial): desde la metodología de desarrollo hasta la seguridad de los puestos de trabajo. Y es que el governance (yo lo entiendo así) es el ‘como se hacen las cosas’, y por eso hay que definirlo bien, ya que sino las cosas se nos irán de madre. ¿Y qué tiene esto que ver con la seguridad? ¿Qué hace el governance compartiendo espacio en este foro a veces técnico, a veces legal pero siempre interesante? Pues señores, el governance y la seguridad deben ir ligados como si fueran parte de la fórmula de la Coca-cola. Pero, ¿por qué la Coca-cola? Pues porque nadie conoce realmente como se fabrica (bueno, espero que alguien sí lo sepa), y porque el governance no es una metodología, no es tangible, no es medible (bueno, existen aproximaciones), pero es necesario conjugarlo bien en todos los puntos para que no nos salga gaseosa marrón.

El governance y la seguridad comienzan desde el momento que se define que es neceasario ‘gobernar’ la situación para que esto no se vaya de madre. Por ejemplo, en desarrollos de arquitecturas SOA (software) se habla de que la seguridad debe estar desde el nacimiento y esto es parte del governance —y mira que se habla de governance cuando alguien menciona SOA… En la gestion de CPD’s (no estoy muy ducho en este tema, francamente) podríamos hablar que el governance debe velar porque los aspectos de seguridad se tengan en cuenta, en la integración de los sistemas (no en un proyecto de integración sino en el uso de ESB, EAI o simples hubs made-in-house) el governance debe velar entre otras cosas por que las interfaces sigan estándares y la integración, monitorización, control y deploy sea correcto (disponibilidad de servicios aparte de su desarrollo, finalmente algo de seguridad), en infraestructura de redes podríamos hablar de tener en cuenta la alta disponibilidad de hardware, el caudal de datos, los procedimientos operativos…

En fin, el governance es una pieza fundamental de cómo hacer las cosas, de qué cosas hacer y de quién debe hacerlas. Para mí es como ver una pirámide a vista de pájaro. Es la única manera de ver realmente todas las caras, incluso la no visible, y de esa forma entender de forma clara la estructura. Es por eso que las pirámides deben verse desde el cielo, pero construirse desde la base. Así que si alguno de ustedes pretende cogerle el gusto al governance, no comiencen por alzar la vista mirando al techo (N.d.E. cosa que, se lo digo yo, no sirve de nada más que para acabar mal de las cervicales), evalúen las situaciones desde los mandos intermedios (generalmente mas operativos), definan los objetivos (con ellos) y aprovechen su conocimiento para llevar a cabo las acciones procedimentales/técnicas/organizativas que deben asegurar que se esta gobernando la situación.

Para hoy martes tenemos una entrada de Rafa García, amigo y antiguo colaborador de S2 Grupo que

Para hoy martes tenemos una entrada de Rafa García, amigo y antiguo colaborador de S2 Grupo que  Terminamos con éste la serie de artículos sobre la implantación de un IDS en un entorno con una alta tasa de tráfico, donde veremos las soluciones que se han tomado para el problema de los paquetes descartados y la escritura en base de datos.

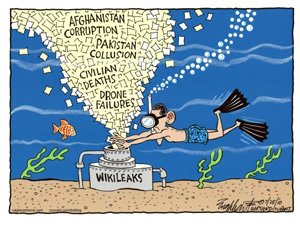

Terminamos con éste la serie de artículos sobre la implantación de un IDS en un entorno con una alta tasa de tráfico, donde veremos las soluciones que se han tomado para el problema de los paquetes descartados y la escritura en base de datos. Ahora que ha pasado un cierto tiempo desde el escándalo de la publicación de los

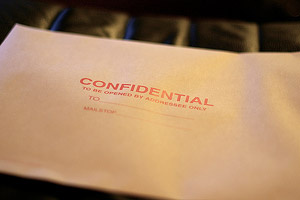

Ahora que ha pasado un cierto tiempo desde el escándalo de la publicación de los  Hace unos días leí una noticia que me llamo la atención; por lo visto, algún trabajador de Google había filtrado a la prensa un comunicado interno (el cual indicaba expresamente que era confidencial) donde se informaba sobre un aumento del 10% del sueldo a todo la plantilla de Google y la recepción de una paga extra de 1000 $ (yo pensé mira que majos :) ). Un día más tarde al hilo de esta noticia aparecía una nueva, en la cual se informaba acerca del despido de la persona que había filtrado la información, que ya no podría disfrutar de ese aumento de sueldo.

Hace unos días leí una noticia que me llamo la atención; por lo visto, algún trabajador de Google había filtrado a la prensa un comunicado interno (el cual indicaba expresamente que era confidencial) donde se informaba sobre un aumento del 10% del sueldo a todo la plantilla de Google y la recepción de una paga extra de 1000 $ (yo pensé mira que majos :) ). Un día más tarde al hilo de esta noticia aparecía una nueva, en la cual se informaba acerca del despido de la persona que había filtrado la información, que ya no podría disfrutar de ese aumento de sueldo.