No malinterpreten el título de este post. A diferencia de algunos “elementos” del mercado no estoy, ni mucho menos, en contra de los libros electrónicos y menos del dispositivo de Amazon. Todo lo contrario, fui de los primeros en adquirir uno. Invertir en un libro electrónico es invertir en salud y si no lo creen ustedes no duden en preguntarle a mi espalda. Tengo muchas ganas de que mis hijas puedan ir al colegio con una mochila en la que lo más pesado sea su bocadillo o su zumo, aunque creo que tendré que esperar a que estén en la Universidad a juzgar por la reacción que las editoriales españolas están teniendo en esta materia. En mi modesta opinión es una vergüenza, pero es lo que tenemos.

No malinterpreten el título de este post. A diferencia de algunos “elementos” del mercado no estoy, ni mucho menos, en contra de los libros electrónicos y menos del dispositivo de Amazon. Todo lo contrario, fui de los primeros en adquirir uno. Invertir en un libro electrónico es invertir en salud y si no lo creen ustedes no duden en preguntarle a mi espalda. Tengo muchas ganas de que mis hijas puedan ir al colegio con una mochila en la que lo más pesado sea su bocadillo o su zumo, aunque creo que tendré que esperar a que estén en la Universidad a juzgar por la reacción que las editoriales españolas están teniendo en esta materia. En mi modesta opinión es una vergüenza, pero es lo que tenemos.

Mostrada mi postura claramente a favor de semejante utensilio del siglo XXI he de hacer una puntualización a mi apoyo. Un apoyo, por tanto, condicional, con alguna fisura fruto de la falta de previsión de los fabricantes o de los ingenieros que lo diseñaron y que se está resolviendo con las últimas versiones del software que se están publicando (versión 2.5.2).

No sé si ustedes se han parado a pensar en el impacto que sobre la sociedad van a tener, o están teniendo ya, los libros electrónicos. Creo que va a ser una revolución a corto plazo equivalente a la de la fotografía digital. El impacto en todos los ámbitos de la sociedad ya se está empezando a notar. Hasta hace no mucho los libros electrónicos eran unas maquinitas con una utilidad incuestionable para los devoradores de novelas, libros de bolsillo, ensayos y demás piezas literarias.

Los que queríamos el libro electrónico como dispositivo simultáneamente de ocio y negocio le encontrábamos algunas pegas, sobre todo por lo relacionado con el tamaño y la calidad de visualización de documentos en tamaño A4, fundamentalmente documentos en formato pdf. Pero los libros electrónicos de 10 pulgadas ya han irrumpido en nuestras vidas y con ellos llegó un nuevo capítulo de preocupación para los que nos dedicamos a la seguridad.

¿Por qué a los señores de Amazon no se les ocurrió inicialmente dotar de algún mecanismo mínimo de seguridad al Kindle DX? Si de verdad se postula este dispositivo para llevar una versión digital del Quijote o el último documento de auditoría de seguridad entregado por nuestro equipo externo de consultores ¿no creen ustedes que debería haberse pensado desde el principio en algún mecanismo de seguridad que garantizase la confidencialidad de la información contenida en el mismo? ¿Qué pasa si al director de RRHH de una gran empresa le roban su Kindle con una versión de la aplicación inferior a la 2.5.2 donde, con el fin de aprovechar los ratos muertos del aeropuerto, había guardado el borrador del ERE que se está diseñando o la lista de los empleados que van a ser despedidos durante este ejercicio? Amazon lo ha intentado resolver hace poco tiempo con su nueva versión de la aplicación pero, ¿qué está ocurriendo con el resto de libros electrónicos?

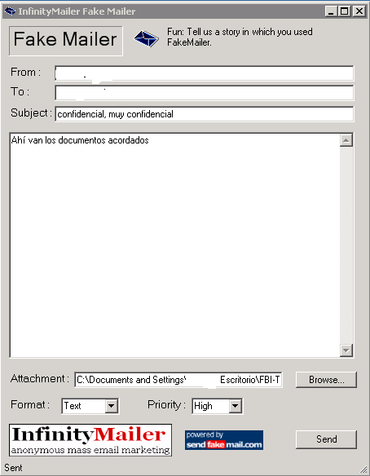

Pero aquí no termina la historia. Como ustedes supongo sabrán Kindle hace uso de una maravillosa red global, Whispernet, mediante la cual estos dispositivos están permanentemente conectados. Esto tiene en si mismo utilidades incuestionables de las cuales hago uso con cierta frecuencia, como por ejemplo “comprar” libros en el portal de Amazon con un solo click y con una seguridad cuestionable, pero también nos permite recibir en nuestro dispositivo correos electrónicos a través de una cuenta gratuita que se nos proporciona con la compra del dispositivo. La seguridad que nos propone Amazon para que los correos sean lícitos es la de dar de alta listas blancas de remitentes de correo. ¿Creen ustedes que es esto suficiente? La respuesta es evidente: NO y si no miren ustedes la figura adjunta que muestra una utilidad mediante la cual enviar correos haciendo uso de una cuenta falsa. Además, la estructura de la cuenta de los clientes es una estructura estándar y por tanto fácilmente deducible en un gran número de casos. El envío de correos electrónicos a esa cuenta tiene muchísima utilidad y un pequeño coste asociado. El problema radica en la falta de seguridad de este mecanismo. A priori cualquiera, con ciertos conocimientos perfectamente alcanzables, te puede enviar un documento que como por arte de magia aparece en tu kindle. Esto quiere decir que en “mi” dispositivo puede aparecer un documento “incómodo” sin haberlo cargado yo y sin tener posibilidad de saber quién lo ha introducido en el sistema. ¡¡Vaya!! Esto puede tener algunas utilidades curiosas más allá incluso del coste asociado que lleva, simplemente hace falta dejar volar un poco la imaginación, ¿no creen?

Al margen de este “pequeño” detalle otra cuestión a tener muy en cuenta por la propia existencia de esa “conexión global” es la seguridad de la conexión inalámbrica en si misma o la capacidad que tiene el propio Amazon de acceder a todos los dispositivos del mundo y, por ejemplo, eliminar un determinado documento o actualizar el firmware en remoto como ya ha ocurrido.

En fin, creo que a pesar de que el Kindle DX es un magnífico instrumento lleno de posibilidades, también creo que en las versiones actuales del dispositivo debemos de llevar bastante cuidado con el uso que del mismo hacemos sobre todo cuando de trabajo se trata. Mientras tanto suplicaremos para que los ingenieros que desarrollan aplicaciones o productos en la era digital se acostumbren, de una vez por todas, a hacer desde el principio un catálogo de “CASOS DE ABUSO” en paralelo al maravilloso catálogo de “CASOS DE USO” que seguro ya hacen. ¿Por qué no se dedican a pensar brevemente en cómo se pueden “mal usar” los dispositivos que diseñan? O mejor aún ¿Por qué no contratan empresas especializadas (dicho sea de paso, como S2 Grupo :), repletas de profesionales que dedican su inteligencia y su tiempo a pensar precisamente en esto?

Disfruten señores de sus libros electrónicos pero, por favor, con “sentido común”

El Sistema de Gestión de Innovación (SG I+D+i) contribuirá a alcanzar los objetivos de la organización fomentando y potenciando las actividades de I+D+i, proporcionará una guía para la correcta gestión de los recursos dedicados a la innovación, aumentará la competitividad y del crecimiento empresarial, etc. Para ello, podemos partir de las indicaciones de la norma UNE 166002 como base para el diseñó de nuestro SG I+D+i.

El Sistema de Gestión de Innovación (SG I+D+i) contribuirá a alcanzar los objetivos de la organización fomentando y potenciando las actividades de I+D+i, proporcionará una guía para la correcta gestión de los recursos dedicados a la innovación, aumentará la competitividad y del crecimiento empresarial, etc. Para ello, podemos partir de las indicaciones de la norma UNE 166002 como base para el diseñó de nuestro SG I+D+i.