Imagen cortesía de http://www.expower.es/

En España, hay 12.000 incendios domésticos al año por electricidad, que causan un número de muertes un 50% superior al de los países comunitarios. El 67% de las casas presenta dos o más deficiencias en la instalación eléctrica, el 19% tienen un único fallo y sólo un 14% de las casas son seguras.

Este problema viene relacionado con el incremento de electrodomésticos y aparatos de alto consumo. Más de dos tercios de los hogares de la UE tienen más de 30 años, pero en España -pese al fuerte ritmo constructor- el 56% de las casas son anteriores a 1970. Según el Consejo General de Aparejadores y Arquitectos Técnicos de España (CGATE) “las causas más habituales de deficiencias eléctricas son la escasa sección de los circuitos para la potencia real utilizada”. Y es que estamos obsoletos. Si tenemos revisiones obligatorias en nuestras instalaciones de gas, ¿Por qué no están reguladas igualmente las eléctricas?

Cuando planificamos y realizamos copias de seguridad de datos y servidores de nuestro negocio, no es raro que a menudo nos olvidemos de una parte no menos importante que la información alojada en los propios servidores y, a veces, vital: las bases de datos PIM (Personal Information Management) .

Cuando planificamos y realizamos copias de seguridad de datos y servidores de nuestro negocio, no es raro que a menudo nos olvidemos de una parte no menos importante que la información alojada en los propios servidores y, a veces, vital: las bases de datos PIM (Personal Information Management) .  (N.d.E. Durante el fin de semana hemos estado haciendo algunos cambios en el blog, para lo que tuvimos que desactivar algunas funcionalidades. En cualquier caso, ahora todo debería funcionar correctamente)

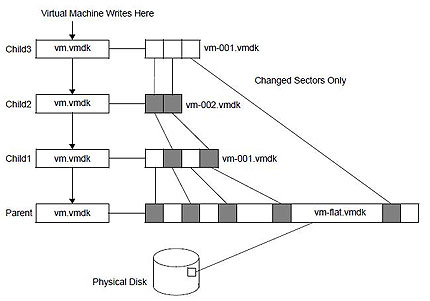

(N.d.E. Durante el fin de semana hemos estado haciendo algunos cambios en el blog, para lo que tuvimos que desactivar algunas funcionalidades. En cualquier caso, ahora todo debería funcionar correctamente) Otra cuestión a tomar en cuenta es la generación de snapshots sobre snapshots. Me explico con un ejemplo: antes de una intervención hemos generado un snapshot, todo ha ido bien, pero no lo borramos “por si acaso”. Al poco tiempo tenemos otra intervención en el mismo servidor, y generamos de nuevo otro snapshot. Esto es totalmente posible y se hace habitualmente, pero no creo que sea una práctica recomendable. El resultado es que se van generando “discos hijos”, cada uno con sus puntos de cambios, y al final el disco virtual inicial acaba siendo una segregación de ficheros, los cuales en caso de error son mucho más complicados de tratar. Personalmente, después de una intervención tras comprobar que todo ha ido bien siempre consolido los snapshots, con lo cual se vuelven a fundir los discos en uno sólo. Tal vez el gráfico que se muestra (fuente

Otra cuestión a tomar en cuenta es la generación de snapshots sobre snapshots. Me explico con un ejemplo: antes de una intervención hemos generado un snapshot, todo ha ido bien, pero no lo borramos “por si acaso”. Al poco tiempo tenemos otra intervención en el mismo servidor, y generamos de nuevo otro snapshot. Esto es totalmente posible y se hace habitualmente, pero no creo que sea una práctica recomendable. El resultado es que se van generando “discos hijos”, cada uno con sus puntos de cambios, y al final el disco virtual inicial acaba siendo una segregación de ficheros, los cuales en caso de error son mucho más complicados de tratar. Personalmente, después de una intervención tras comprobar que todo ha ido bien siempre consolido los snapshots, con lo cual se vuelven a fundir los discos en uno sólo. Tal vez el gráfico que se muestra (fuente  Son muchas las recomendaciones hechas por ITIL en su Gestión de Incidencias, todas útiles y de implantación obligatoria. Eso sí, ITIL no te las va a resolver, sino que te va a ayudar para establecer un proceso para gestionar cada una de las incidencias, aprender de ellas, ser más proactivos y reactivos, obtener mejoras de cada una de ellas y aplicarlas a la infraestructura IT que se tenga, que no es poco…

Son muchas las recomendaciones hechas por ITIL en su Gestión de Incidencias, todas útiles y de implantación obligatoria. Eso sí, ITIL no te las va a resolver, sino que te va a ayudar para establecer un proceso para gestionar cada una de las incidencias, aprender de ellas, ser más proactivos y reactivos, obtener mejoras de cada una de ellas y aplicarlas a la infraestructura IT que se tenga, que no es poco…  En nuestro trabajo habitual, a menudo nos hemos encontrado con información muy útil sobre aplicaciones de backups, tales como problemas solucionados, scripts de uso, consejos de optimización, trucos, etc.

En nuestro trabajo habitual, a menudo nos hemos encontrado con información muy útil sobre aplicaciones de backups, tales como problemas solucionados, scripts de uso, consejos de optimización, trucos, etc.