Tras los comentarios recibidos sobre el post “De que hablo cuando hablo de…”, he creído conveniente dedicar a nuestros lectores una segunda parte del mismo. Me gustaría matizar que en esta ocasión la entrada está más enfocada al mundo legal y normativo relacionado con las TIC. Por otra parte intentaré ser más descriptivo en las definiciones de estos términos. Así que sin más dilación prosigamos con el mundo de los acrónimos TIC:

BCMS/SGCN (Business Continuity Management System / Sistema de Gestión de Continuidad de Negocio): Sistema de gestión definido en el marco de la norma ISO 22301, anteriormente BS25999-1, que se implementa siguiendo el ciclo de Deming también conocido como PDCA (Plan-Do-Check-Act) que comprende la política, la estructura organizativa, los procedimientos, los procesos y los recursos necesarios para implantar la continuidad de negocio en una entidad.

Para cualquiera que haya estudiado una carrera universitaria de informática o algún programa educativo similar es evidente que en sus contenidos no se tratan, en la mayor parte de los casos, las tecnologías específicas de fabricantes como Microsoft, CISCO, HP, EMC2 etc. Asimismo, por lo general la formación en materia de seguridad suele brillar por su ausencia, tanto en el ámbito de la gestión (SGSIs, Análisis de riesgos, etc.) como en la parte más técnica (pentesting, análisis forense, etc.). En definitiva, que una vez acabada la fase eminentemente académica y ya de pleno en el mundo laboral, puede ser interesante ampliar los conocimientos, algo que puede hacerse a través de la experiencia a lo largo de los años, autoformación y buenos profesionales en los que apoyarse, a través de formación reglada (esto ya lo vimos

Para cualquiera que haya estudiado una carrera universitaria de informática o algún programa educativo similar es evidente que en sus contenidos no se tratan, en la mayor parte de los casos, las tecnologías específicas de fabricantes como Microsoft, CISCO, HP, EMC2 etc. Asimismo, por lo general la formación en materia de seguridad suele brillar por su ausencia, tanto en el ámbito de la gestión (SGSIs, Análisis de riesgos, etc.) como en la parte más técnica (pentesting, análisis forense, etc.). En definitiva, que una vez acabada la fase eminentemente académica y ya de pleno en el mundo laboral, puede ser interesante ampliar los conocimientos, algo que puede hacerse a través de la experiencia a lo largo de los años, autoformación y buenos profesionales en los que apoyarse, a través de formación reglada (esto ya lo vimos  El 8 de noviembre de 2009, Ryan Dahl presentó Node.js como un entorno de desarrollo en JavaScript de lado de servidor, totalmente asíncrono y

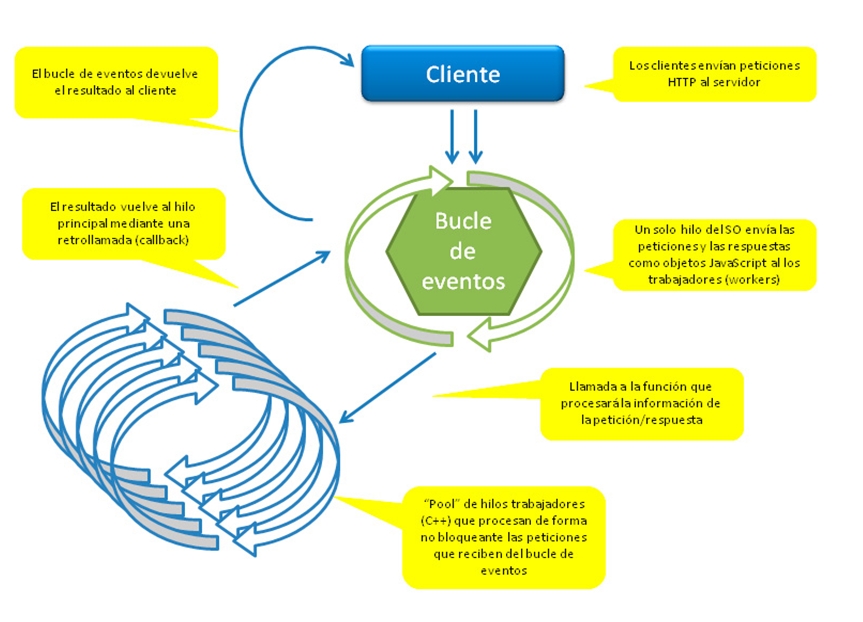

El 8 de noviembre de 2009, Ryan Dahl presentó Node.js como un entorno de desarrollo en JavaScript de lado de servidor, totalmente asíncrono y